Microsoftは年次カンファレンス「Microsoft Ignite」で、AIワークロード向けの2つの自社製チップを発表しました(Neowin)。

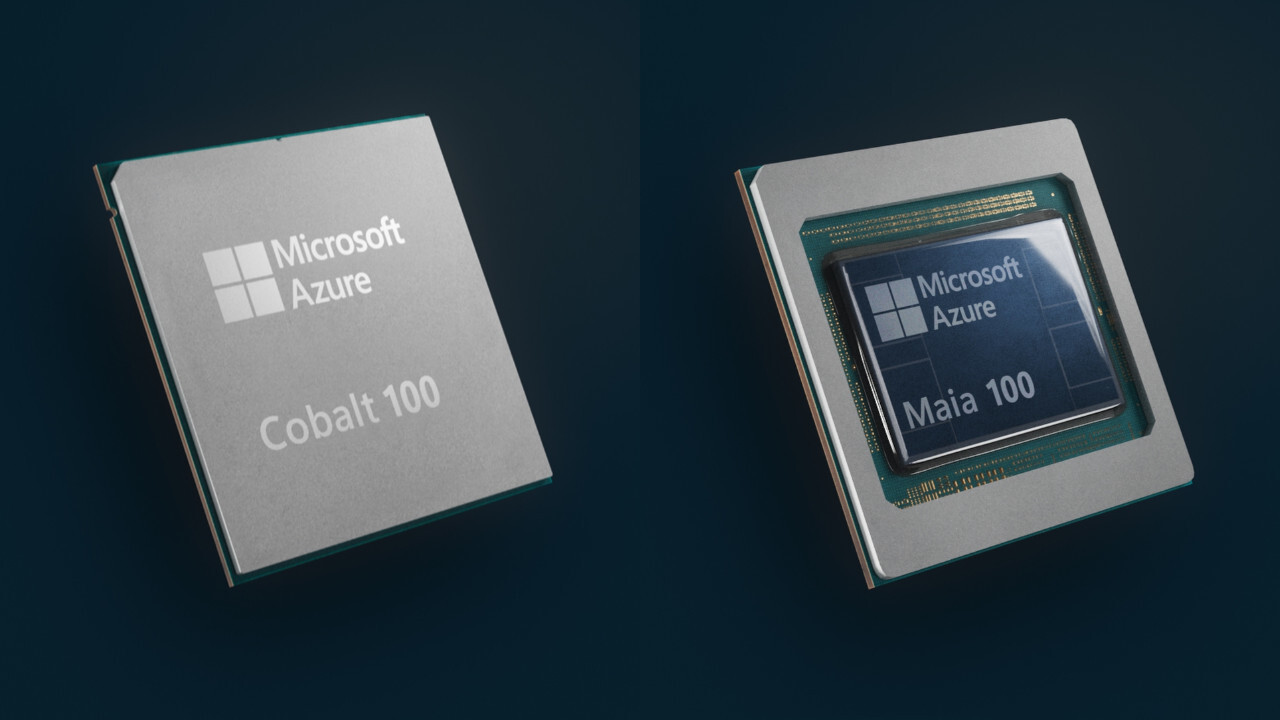

発表されたのは、人工知能タスクや生成AI向けの「Microsoft Azure Maia AI Accelerator」と、Microsoftのクラウド上で汎用コンピューティングワークロードを実行するために調整されたARMプロセッサー「Microsoft Azure Cobalt」です。

Microsoftのチップ開発の背景には、AIに対する需要を満たすために、「シリコンからサービスまでのすべて」を調整するという考えがあります。自社製チップを開発する以外にも、ソフトウェア、サーバーラック、冷却システムなど、あらゆるものがAIワークロード用に最適化されています。

Microsoft is building the infrastructure to support AI innovation, and we are reimagining every aspect of our datacenters to meet the needs of our customers. At the scale we operate, it's important for us to optimize and integrate every layer of the infrastructure stack to maximize performance, diversify our supply chain and give customers infrastructure choice.

Microsoftは、AIイノベーションをサポートするインフラを構築しており、お客様のニーズを満たすために、データセンターのあらゆる側面を再構築しています。私たちが事業を展開する規模では、パフォーマンスを最大化し、サプライチェーンを多様化し、お客様にインフラの選択肢を提供するために、インフラスタックのあらゆるレイヤーを最適化し、統合することが重要です。

MicrosoftによるとAzure Maia AI AcceleratorはAzureハードウェアスタック専用に設計されており、「ハードウェアの絶対最大利用率」を達成するとのこと。Azure Cobaltに関しては、データセンターにおけるワットあたりの性能比を最適化した、クラウドネイティブオファリング向けのエネルギー効率の高いARMチップであると説明されています。

新しいチップを既存のデータセンター・インフラに搭載するため、Microsoftはサーバーラックの設計を変更し(新しいプロセッサーにはより幅の広いボードが必要)、液冷ソリューションを導入しています。同社は、新しいプロセッサーを来年初めにデータセンターに展開し、まずはMicrosoft CopilotとAzure OpenAI Serviceに搭載する予定です。

Microsoftは独自のプロセッサの開発するだけではなく、他のメーカーとの提携も拡大し、顧客により多くの選択肢を提供する予定です。NvidiaのH100 Tensor Core GPUを搭載した新しい仮想マシンのプレビューを開始し、NVIDIA H200 Tensor CoreとAMDのMI300Xの採用も計画しています。