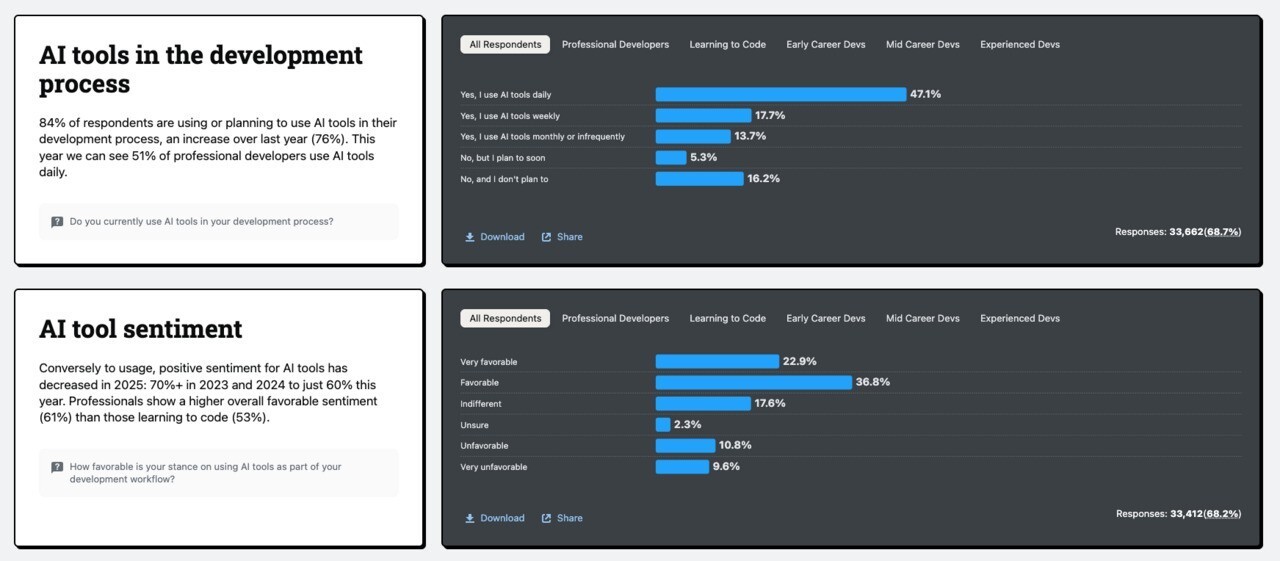

2025年の定期Stack Overflow開発者調査は、AIコード支援ツールに対する開発者の見方が大きく変化していることを浮き彫りにしました。信頼と好意度は明確に下落しつつも、利用率は増加するという相反する状況が、いま開発現場で進行中であることが判明しています(LeadDev)。

この調査では、AIツールの精度への信頼性が2024年の43%から2025年は33%へ減少。ワークフローへの導入に好意的な意見も72%から60%に急落しています。それに対して実際の使用率は、84%がAI支援ツールを使用中または導入を検討中と増加しています。

このデータは、AIツールの「人気低下」を示すものではなく、むしろ、開発者の評価が成熟し、より現実的になってきた証だと読み解くべきだととらえられています。

期待と現実のギャップ

Stack Overflowのシニアアナリスト、Erin Yepis氏は、AIツールが単純な作業に対してすら満足度が低いことを指摘します。特に、既に自分でこなせるタスクに対してAIを使うと、かえって不満が生じるケースが多いとのこと。

さらに、Black Duck社のセキュリティ部門ディレクターRaj Kesarapalli氏は、「AIの限界を理解する開発者が増え、利用が戦略的になってきている」と語っています。これは初期のハイプ(過剰な期待)から、実用フェーズへとシフトしている兆候です。

AIを適材適所で使う

調査によれば、AIによる出力を信頼できない場合、4人に3人が人間の判断に立ち返ると回答。フィンテック分野でCTOとして活躍したAndrey Korchak氏は「AIに夢を見て試したが、構造を壊したり誤ったコードを吐き出すことで失望する」との事例を挙げています。

ただし、これはAIを見限るのではなく「適材適所で使う」動きでもあります。69%のAI利用者が「生産性が向上した」と回答し、開発者たちは、AIが得意な分野(ルーチン業務、コードテンプレート生成など)で効率化を実感と回答しています。

Stack Overflowの調査チームは「この進化は自然な流れであり、技術の成熟に伴う現実的な受け入れ」と結論づけています。

Redditで語られる現場のリアル

Redditのr/programmingスレッドでも、開発者たちがこの調査結果に関して率直な意見を交わしています。

以下は代表的な声です:

-

「AIが生成するコードはほぼ正しいけど、微妙なバグを仕込むから逆に厄介」

→ Ars Technicaも同様に、"almost right"な出力が最大の不満点と報告 -

「AIの提案をそのまま使うと、後でStack Overflowに助けを求める羽目になる」

→ 実際、AI関連の問題でStack Overflowを訪れる開発者が増加 -

「AIはサイレントな相棒ではなく、"議論相手"として使うべき」

→ AIを"sparring partner"として捉えることで、学習効率が上がるという意見も

AIコード支援ツールは、もはや開発現場に欠かせない存在です。しかし、盲目的な信頼から、戦略的な活用へとフェーズが移行していることがわかります。むやみに騒ぎ立てるのではなく冷静に「AIとの付き合い方」を再定義する時期に来ているといえそうです。