ChatGPTやCopilotなど、AIチャットボットが急速に普及していますが、これらのAIチャットボットはクラウド上のサーバーで動作しているものがほんんどです。

クラウドではなくローカルでAIチャットボットを動作させたいという要望が高まっているなか、NvidiaがGeForce RTX GPUを利用し、ローカルでチャットボットを動かすことができる「Chat with RTX」と呼ばれるデモアプリを公開しています(The Verge)。

Nvidiaはこのデモアプリを次のように説明しています。

Chat With RTX is a demo app that lets you personalize a GPT large language model (LLM) connected to your own content—docs, notes, videos, or other data. Leveraging retrieval-augmented generation (RAG), TensorRT-LLM, and RTX acceleration, you can query a custom chatbot to quickly get contextually relevant answers. And because it all runs locally on your Windows RTX PC or workstation, you’ll get fast and secure results.

Chat With RTXは、独自のコンテンツ(ドキュメント、メモ、ビデオ、その他のデータ)に接続されたGPT大規模言語モデル(LLM)をパーソナライズできるデモアプリです。検索拡張世代(RAG)、TensorRT-LLM、RTXアクセラレーションを活用することで、カスタムチャットボットにクエリを発行し、コンテキストに関連した回答を素早く得ることができます。また、Windows RTX PCやワークステーション上でローカルに実行されるため、高速で安全な結果を得ることができます。

アプリを動作させるための要件は以下の通りです。

- プラットフォーム: Windows 11

- GPU: NVIDIA GeForce RTX 30/40 Series GPU、NVIDIA RTX Ampere、Ada Generation GPU(8GB以上のVRAMを搭載)

- RAM: 16GB以上

- OS: Windows 11

- ドライバー: 535.11以降

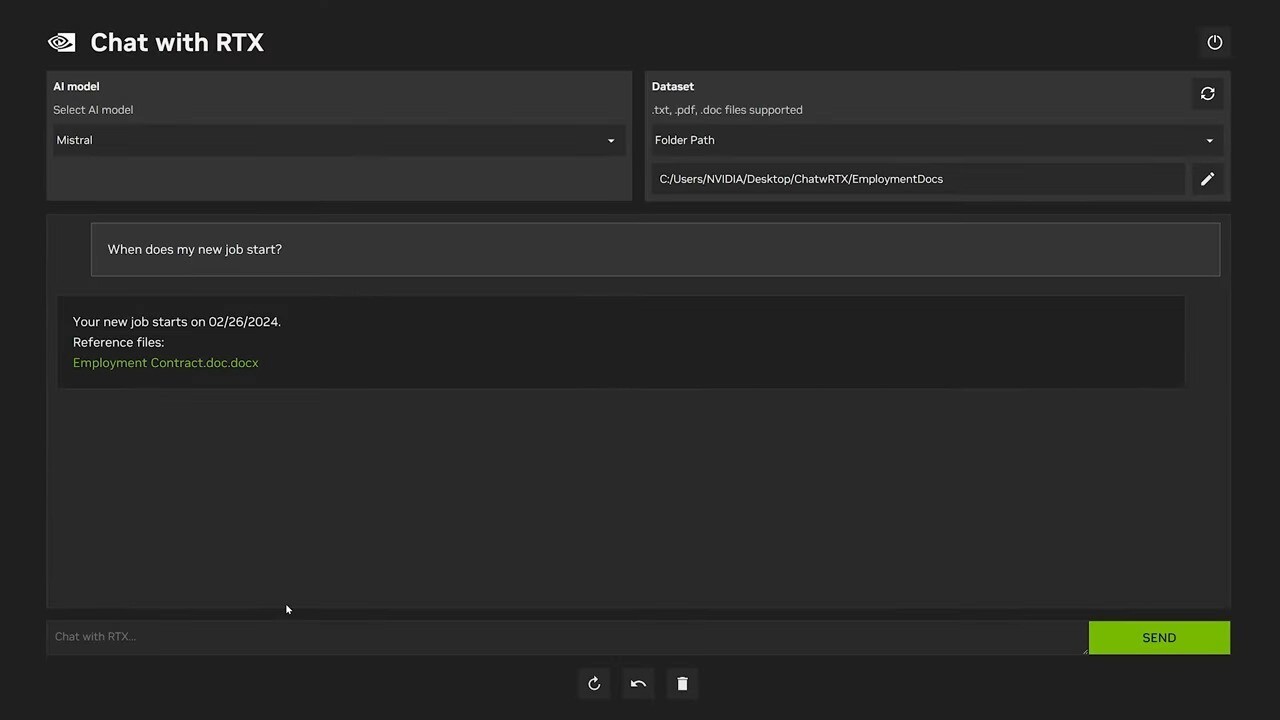

Chat with RTXはテキスト、pdf、doc/docx、xmlなどさまざまなファイル形式をサポートしていて、ファイルを保存したフォルダを指定すると、そのローカルデータを使ってチャットボットに質問することができます。またYouTubeのプレイリストのURLを指定し、動画に関する内容を質問することもできます。

デモアプリはGitHubから入手できるTensorRT-LLM RAG開発者リファレンスプロジェクトから構築されれていて、開発者はこのリファレンスを使用して、独自のRAGベースのアプリケーションを開発することもできます。

ハードウェアの要件が高めですが、クラウドを必要としないAIチャットボットの実装例として注目を集めそうです。