ZedのConrad Irwin氏が「LLMs(大規模言語モデル)は本質的にはソフトウェアを構築できない」と主張したブログ記事を公開し、Hacker Newsでも多くの議論が交わされました。この記事では、記事の主張とそれに対する技術者コミュニティの反応をまとめてみたいと思います。

LLMは「メンタルモデル」を持てない

Irwin氏は、優秀なソフトウェアエンジニアが繰り返す「思考ループ」を以下のように定義しています:

- 要件のメンタルモデルを構築: 何を作るべきか?どんな制約があるか?ユーザーは何を期待しているか?例:「このフォームはユーザー登録用で、メール検証が必要。失敗時は非同期でエラーメッセージを出す」。

- コードを書く: 要件に基づいて、仮説的にコードを実装する

- 実際の挙動を観察し、メンタルモデルを更新する: 実際に動かしてみて、「自分の理解と一致しているか?」を確認する。例:「あれ、非同期処理がうまくいってない。Promiseチェーンの順序が違うかも」。

- 差異を見つけて修正する: 要件と実装のズレを見つけ、コードか要件のどちらを修正するか判断

LLMはこのループのうち、コード生成や修正は得意ですが、「要件の仮説」を持もてず、「コードの挙動を観察して、仮説と照合する」ことができません。「どこがズレているか?」を判断するための"地図"を持っておらず、「明確なメンタルモデルの維持」ができないため、複雑なソフトウェア構築には不向きだと指摘しています。

LLMの主な技術的課題として、「文脈の省略(Context Omission)」「直近バイアス(Recency Bias)」「幻覚(Hallucination)」をあげ、LLMが人間のように「文脈を一時保存して再構築する」能力を持たない理由だとしています。

Hacker Newsでの主な反応

この記事に対しHacker Newsにはさまざまな意見が寄せられています。

賛同意見: LLMは「ジュニアレベル」まで

まず記事に対し、多くのユーザーが「LLMはコード生成には有用だが、設計や抽象化には限界がある」と同意しています。「LLMは文脈を保持できないため、複雑なリファクタリングや設計変更には向いていない」との声もあります。

「AIは"コードを書く"ことはできても、"ソフトウェアを構築する"ことはできない」という象徴的なコメントも寄せられています。

懐疑的な視点:進化はしているが限界も明確

一方、ClaudeやChatGPT-5などの最新モデルを使ったユーザーからは「驚くほどの進化がある」との報告も寄せられています。例えば、「数十件のコード修正を自動化できた」「コンパイルエラーの修正が一瞬で終わる」といった実体験が共有されています。

ただし、手放しでAIの進化に驚くだけでなく「スコープを超えると破壊的な挙動をする」「Separation of Concernsが苦手」など、実務での限界も共有されています。

実体験ベースの議論

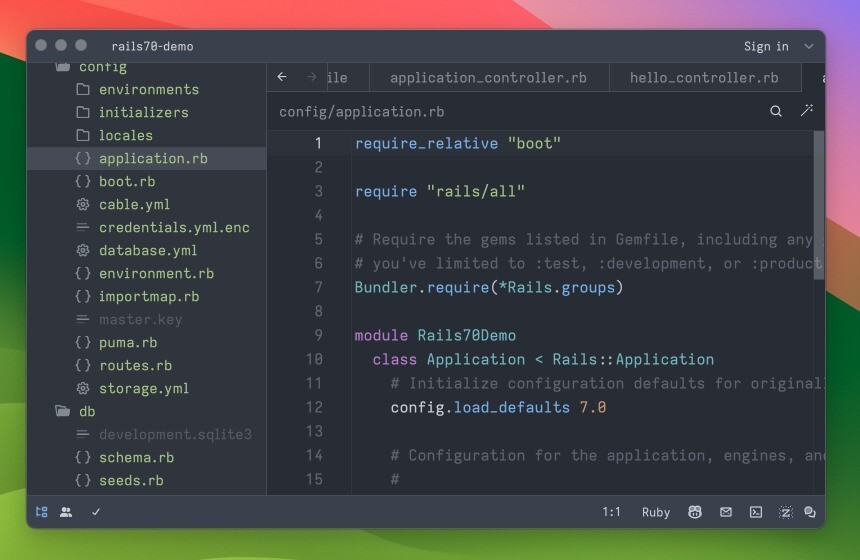

DjangoやC++プロジェクトでCursorを使った体験談では、「初期生成は優秀だが、設計の整合性を保つのは困難」との指摘があります。「AIは理解をシミュレートしているだけで、本質的な理解には至っていない」という見解もあります。

「LLMは自信満々に間違える」というコメントもあり、幻覚や誤解のリスクが強調されています。

結論:LLMは「補助ツール」として活用すべき

Zedの立場は明快です。「人間が主導し、LLMはツールとして活用するべき」というもので、これはZedエディタの設計思想に通じるものもあります。

この主張は、Hacker Newsに寄せられていた「LLMはジュニアエンジニアの作業を高速化するが、シニアレベルの判断や設計には人間が不可欠」という意見とも一致するものとなっています。

編集後記

この議論は、AIと人間の役割分担に関する重要な問いを投げかけています。LLMの進化は目覚ましいものがありますが、「理解」「文脈保持」「抽象化」といった人間の強みは、まだAIが完全に再現することはできていません。今後のモデル設計やメモリ機能の進化が、このギャップを埋める鍵となるのかもしれません。